大家好,欢迎来到IT知识分享网。

文章目录

一、准备环境:

系统版本:CentOS Linux release 7.9.2009 (Core)

三台虚拟机详情:

| 主机名 | CPU | 内存 | IP地址 |

|---|---|---|---|

| k8s-master | 2核 | 2G | 192.168.31.31 |

| k8s-node1 | 1核 | 2G | 192.168.31.152 |

| k8s-node2 | 1核 | 2G | 192.168.31.84 |

二、三个节点都要配置的:

1.修改主机名:

#master节点:

hostnamectl set-hostname k8s-master

#node1节点:

hostnamectl set-hostname k8s-node1

#node2节点:

hostnamectl set-hostname k8s-node2

*此处使用的shell工具不同,若是没有显示修改后的主机名,可以尝试先断开shell连接重新连接。

2.同步三个节点的时间

Kubernetes要求集群中的节点时间必须精确一致

ntpdate time.windows.com

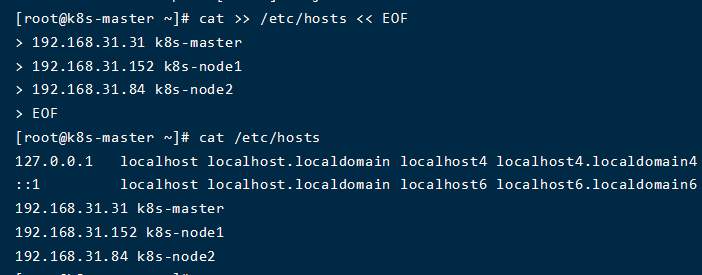

3.主机名解析

方便后面节点间的调用

cat >> /etc/hosts << EOF

192.168.31.31 k8s-master

192.168.31.152 k8s-node1

192.168.31.84 k8s-node2

EOF

4.关闭防火墙

为了方便安装测试,关闭三个节点的防火墙

systemctl stop firewalld

systemctl disable firewalld

5.禁用selinux

测试环境,三个节点均关闭此安全服务,规避后面出现的问题

sed -i 's/^SELINUX=enforcing$/SELINUX=disabled/' /etc/selinux/config

setenforce 0

6.关闭swap分区

swap分区是为了在物理内存不够用的时候,把硬盘内存中的一部分空间释放出来,Kubernetes要求每个节点都禁用此分区

swapoff -a

7.将桥接的IPV4流量传递到iptables的链

iptables是Linux 内核集成的IP信息包过滤系统。为了避免流量丢失,做如下设置

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

加载所有的配置文件

sysctl --system

8.安装Dokcer

分别为三个节点安装Docker

#配置docker yum源

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

#安装指定版本,这里安装18.06

yum install -y docker-ce-18.06.1.ce-3.el7

#开机启动并运行docker

systemctl start docker && systemctl enable docker

9.添加阿里云yum软件源

分别为三个节点配置一下阿里源

#配置kubernetes.repo的源,由于官方源国内无法访问,这里使用阿里云yum源

cat > /etc/yum.repos.d/kubernetes.repo <<EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/

enabled=1

gpgcheck=1

repo_gpgcheck=1

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

10.安装kubeadm、kubelet、kubectl

#在所有节点上安装指定版本 kubelet、kubeadm 和 kubectl

yum install -y kubelet-1.15.0 kubeadm-1.15.0 kubectl-1.15.0

#启动kubelet服务

systemctl enable kubelet && systemctl start kubelet

三、部署 Master 节点

1.Master节点执行初始化

kubeadm init \

--apiserver-advertise-address=192.168.31.31 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.15.0 \

--service-cidr=10.1.0.0/16 \

--pod-network-cidr=10.244.0.0/16

*看到如下警告,无需紧张,等一会就会继续运行了(2~3分钟):

[WARNING IsDockerSystemdCheck]: detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd". Please follow the guide at https://kubernetes.io/docs/setup/cri/

[WARNING Hostname]: hostname "k8s-master" could not be reached

[WARNING Hostname]: hostname "k8s-master": lookup k8s-master on 192.168.31.1:53: no such host

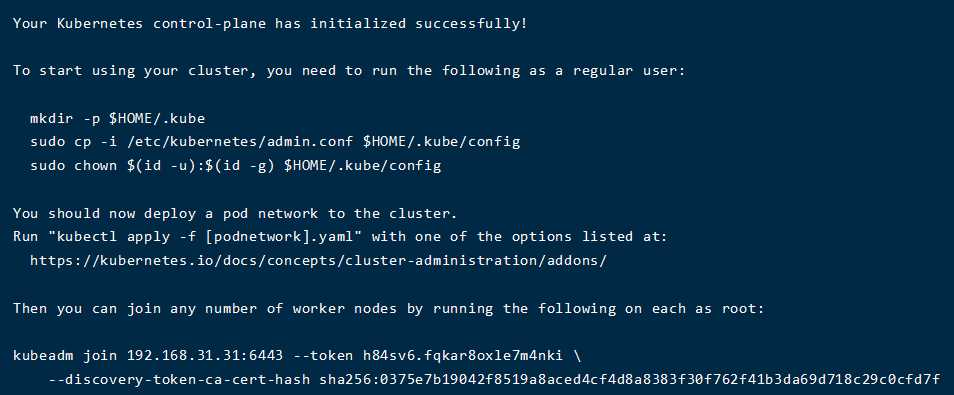

安装成功,会在最后提示如下内容

1)上面要求执行的操作:

有了上面的配置后,后续才能使用 kubectl 工具执行命令

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

2)记录下最后一行的内容!

kubeadm join 192.168.31.31:6443 --token h84sv6.fqkar8oxle7m4nki \

--discovery-token-ca-cert-hash sha256:0375e7b19042f8519a8aced4cf4d8a8383f30f762f41b3da69d718c29c0cfd7f

2.安装pod网络插件(CNI)

安装Kubernetes网络插件,flannel:

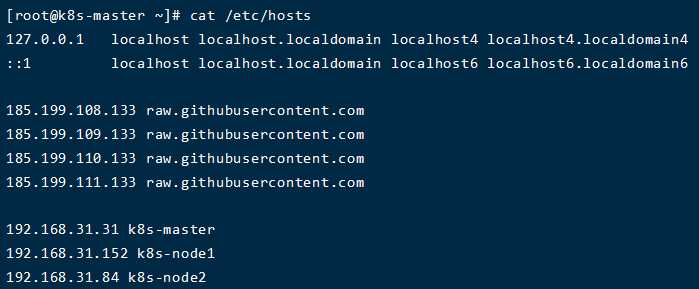

1)将真实IP写入master的hosts文件

由于无法访问到外网,所以我们需要通过在 https://www.ipaddress.com/ 查询raw.githubusercontent.com的真实IP,并写入hosts文件

vim /etc/hosts

185.199.108.133 raw.githubusercontent.com

185.199.109.133 raw.githubusercontent.com

185.199.110.133 raw.githubusercontent.com

185.199.111.133 raw.githubusercontent.com

设置后,master节点的hosts文件

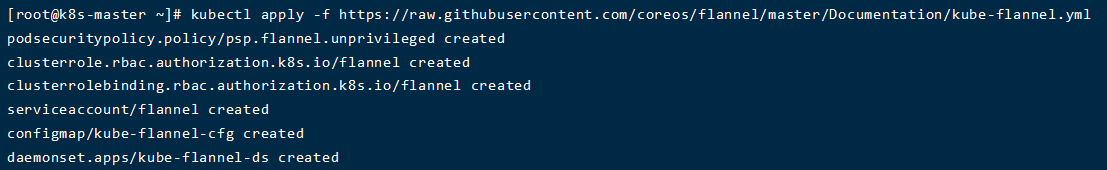

2)安装命令

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

安装成功:

3.查看master节点安装效果

[root@k8s-master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master Ready master 115m v1.15.0

至此,Kubernetes 的 Master 节点就部署完成了~

四、部署 Node 节点

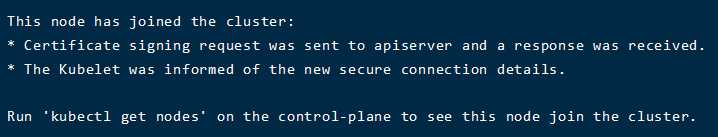

1.将刚刚记录的命令,分别执行到node1 & node2

将node节点加入到集群

kubeadm join 192.168.31.31:6443 --token h84sv6.fqkar8oxle7m4nki \

--discovery-token-ca-cert-hash sha256:0375e7b19042f8519a8aced4cf4d8a8383f30f762f41b3da69d718c29c0cfd7f

*如果上面没有记录kubeadm join那条命令,我们可以通过下面这条命令查看:

kubeadm token create --print-join-command

待到node1&node2均出现一下提示,说明节点已经成功加入集群了

2.通过 kubectl get nodes 查看节点的状态

通过master节点,查看集群中所有的节点

[root@k8s-master ~]# kubectl get nodes

NAME STATUS ROLES AGE VERSION

k8s-master Ready master 127m v1.15.0

k8s-node1 Ready <none> 4m53s v1.15.0

k8s-node2 Ready <none> 4m23s v1.15.0

nodes状态全部为ready,由于每个节点都需要启动若干组件,如果node节点的状态是 NotReady,可以查看所有节点pod状态,确保所有pod成功拉取到镜像并处于running状态:

[root@k8s-master ~]# kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

coredns-bccdc95cf-46q58 1/1 Running 0 128m

coredns-bccdc95cf-m5xjn 1/1 Running 0 128m

etcd-k8s-master 1/1 Running 0 127m

kube-apiserver-k8s-master 1/1 Running 0 127m

kube-controller-manager-k8s-master 1/1 Running 0 127m

kube-flannel-ds-9j4fg 1/1 Running 1 6m41s

kube-flannel-ds-gm5z9 1/1 Running 1 6m11s

kube-flannel-ds-zf2jk 1/1 Running 0 17m

kube-proxy-ff6tr 1/1 Running 0 6m41s

kube-proxy-slnqn 1/1 Running 0 128m

kube-proxy-thc5f 1/1 Running 0 6m11s

kube-scheduler-k8s-master 1/1 Running 0 127m

至此,Kubernetes 的 Node 节点就部署完成了~

五、测试Kubernetes集群

1.在Kubernetes集群中创建一个pod,验证是否正常运行

#在master部署nginx

[root@k8s-master ~]# kubectl create deployment nginx --image=nginx:alpine

#通过NodePort的方式暴露端口号

[root@k8s-master ~]# kubectl expose deployment nginx --port=80 --type=NodePort

2.查看效果

[root@k8s-master ~]# kubectl get pod,svc

NAME READY STATUS RESTARTS AGE

pod/nginx-8f6959bd-4q6gj 1/1 Running 0 61s

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes ClusterIP 10.1.0.1 <none> 443/TCP 132m

service/nginx NodePort 10.1.152.39 <none> 80:32269/TCP 44s

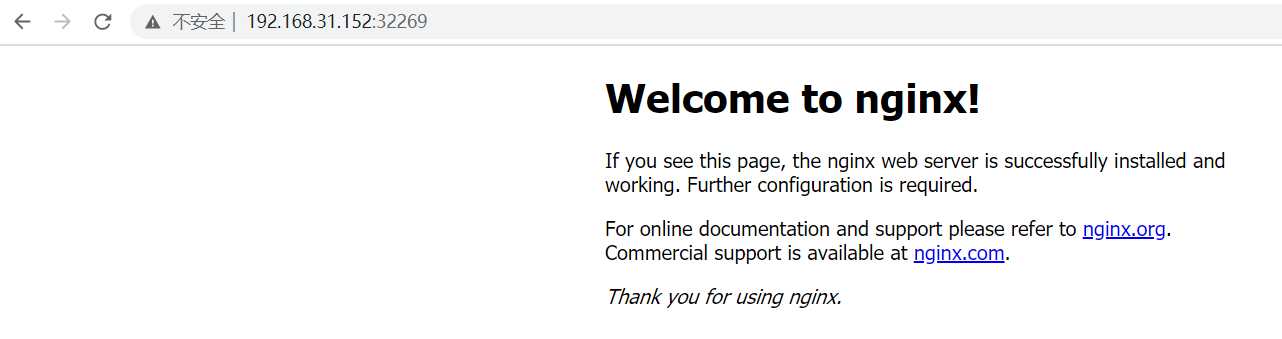

3. 通过node1的ip地址访问nginx

http://192.168.31.152:32269/

测试成功~

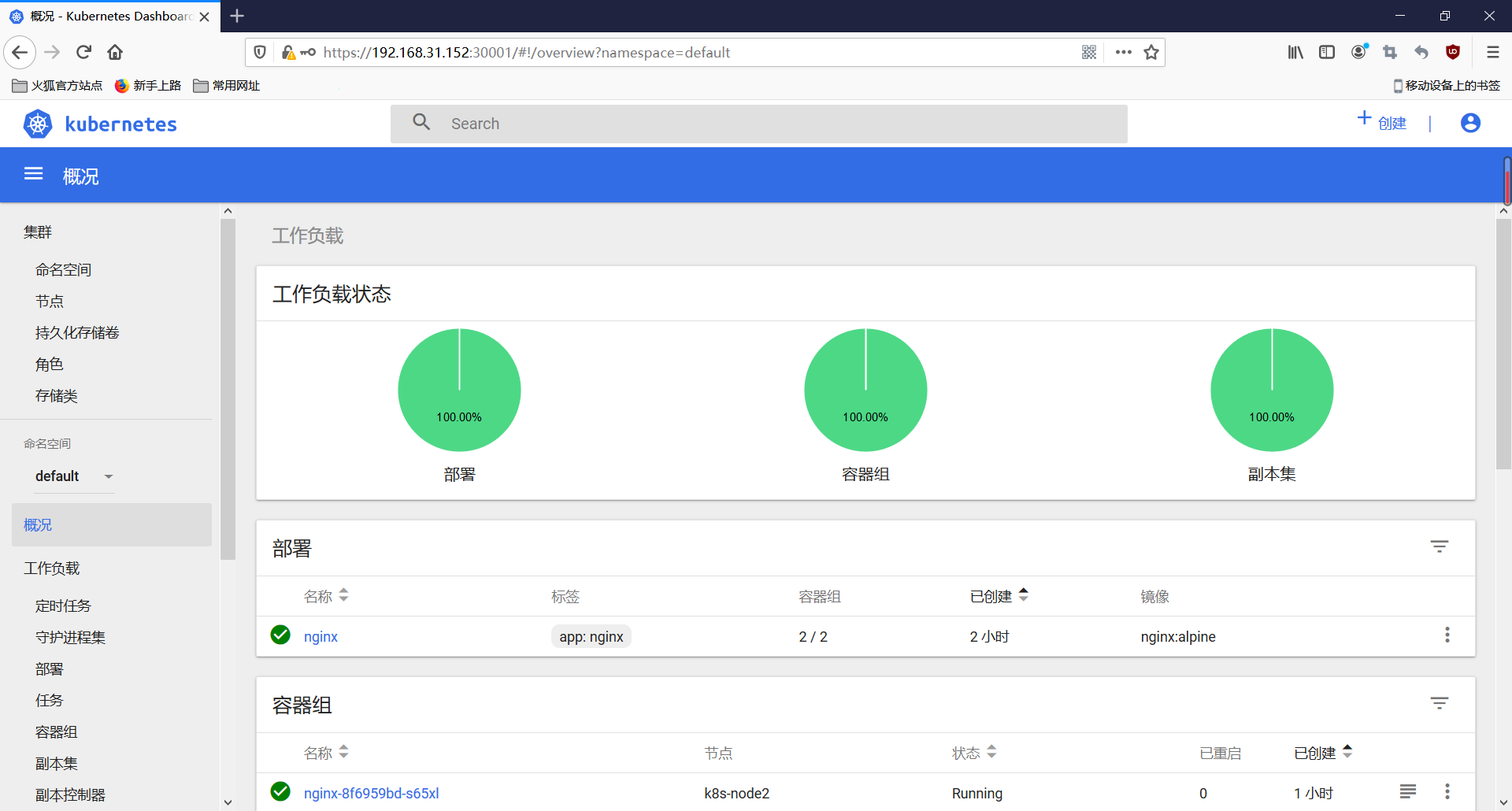

4. 扩容2个副本

[root@k8s-master ~]# kubectl scale deployment nginx --replicas=2

5. 查看一下扩容效果(2个nginx一起提供服务)

[root@k8s-master ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-8f6959bd-4q6gj 1/1 Running 0 12m

nginx-8f6959bd-cl9tz 1/1 Running 0 8m40s

六、部署Dashboard(Kubernetes的UI界面)

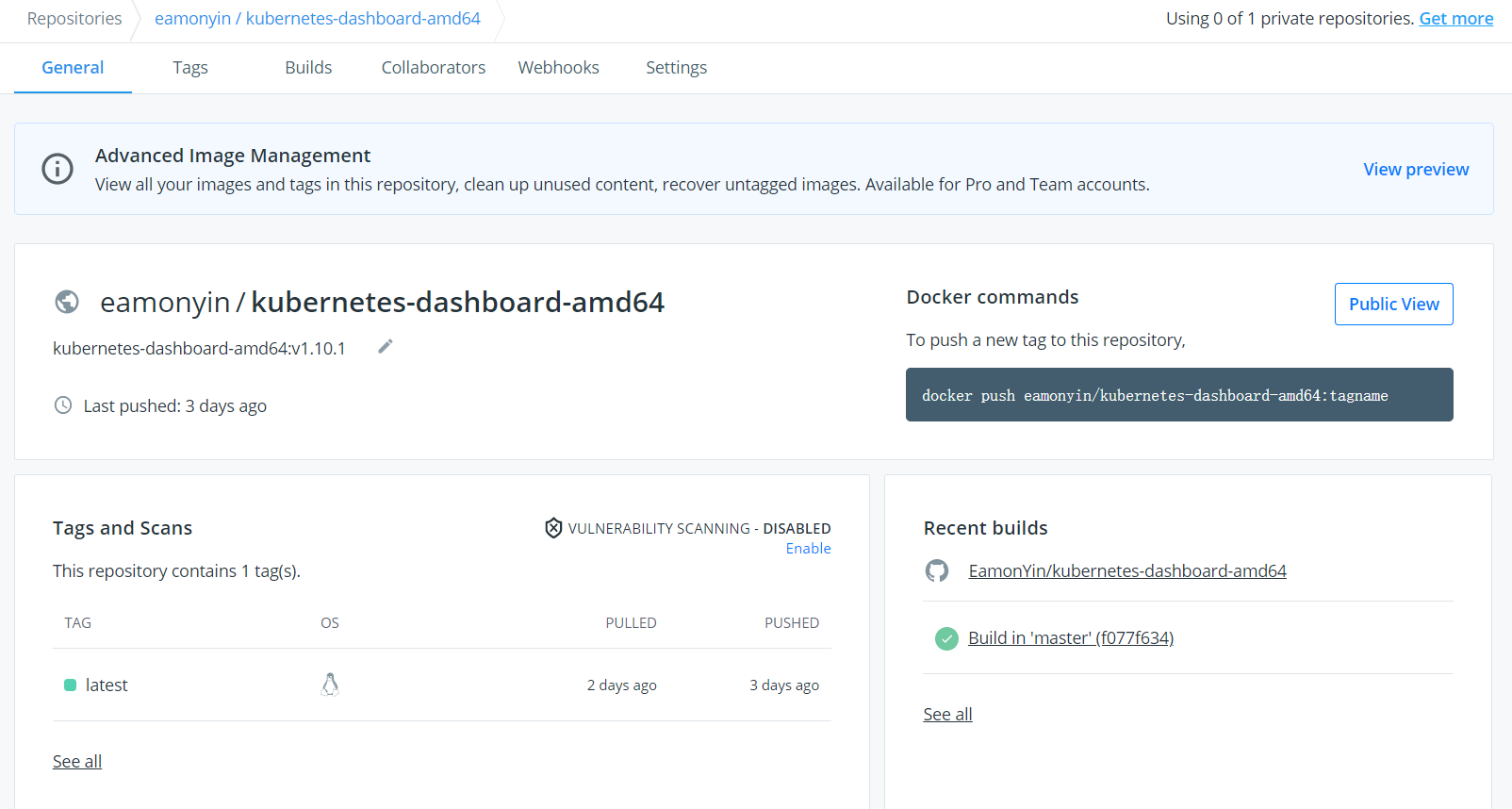

1. 在node1和node2上分别拉取镜像

*此处为了排除网络影响,小名在DockerHub上事先为大家准备好了dashboard镜像,大家可以直接拉取使用

docker pull eamonyin/kubernetes-dashboard-amd64

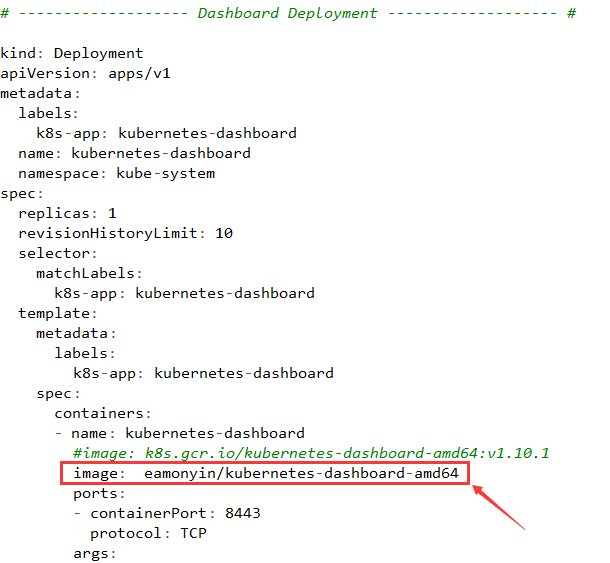

2.创建kubernetes-dashboard服务和对应的pod

1)在master节点执行,获取yaml部署文件

wget https://raw.githubusercontent.com/kubernetes/dashboard/v1.10.1/src/deploy/recommended/kubernetes-dashboard.yaml

2)修改“/root/kubernetes-dashboard.yaml”中的image地址。如果node1和node2上已经拉取了镜像(可以跳过此步)

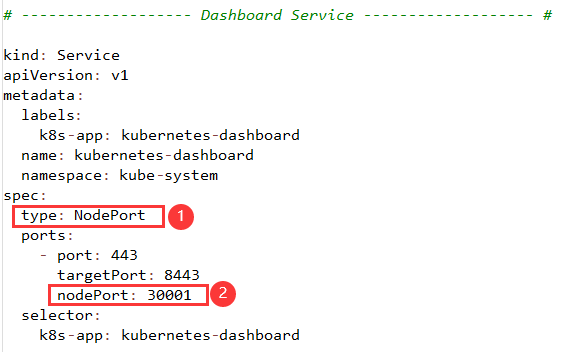

3)添加对外暴露接口规则

添加:

type: NodePort

nodePort: 30001

*配置“type: NodePort ”:为了让集群外的机器可以通过浏览器访问。

*配置“nodePort: 30001”:集群外的机器通过 node节点IP + 暴露端口号 即可访问界面

如下:

3.安装dashboard

kubectl apply -f kubernetes-dashboard.yaml

4.验证dashboard是否启动成功

[root@k8s-master ~]# kubectl get pods -n kube-system

NAME READY STATUS RESTARTS AGE

coredns-bccdc95cf-46q58 1/1 Running 0 4h6m

coredns-bccdc95cf-m5xjn 1/1 Running 0 4h6m

etcd-k8s-master 1/1 Running 0 4h5m

kube-apiserver-k8s-master 1/1 Running 0 4h5m

kube-controller-manager-k8s-master 1/1 Running 0 4h5m

kube-flannel-ds-9j4fg 1/1 Running 2 124m

kube-flannel-ds-gm5z9 1/1 Running 2 123m

kube-flannel-ds-zf2jk 1/1 Running 0 135m

kube-proxy-ff6tr 1/1 Running 1 124m

kube-proxy-slnqn 1/1 Running 0 4h6m

kube-proxy-thc5f 1/1 Running 1 123m

kube-scheduler-k8s-master 1/1 Running 1 4h5m

kubernetes-dashboard-979d4d685-ffjnc 1/1 Running 0 78s

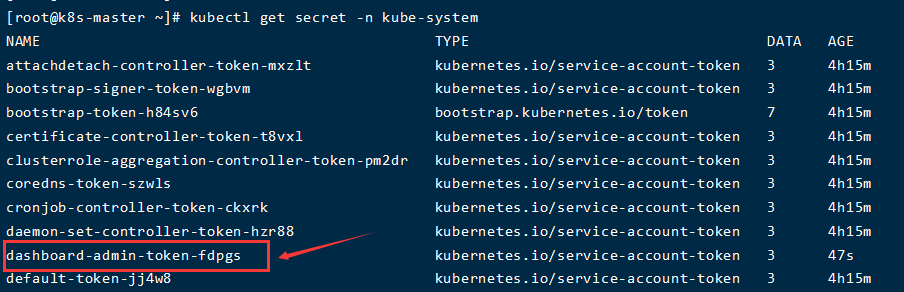

5. 创建serviceAccount,用户名为dashboard-admin

kubectl create serviceaccount dashboard-admin -n kube-system

6.通过clusterrolebinding绑定到内置的cluster-admin角色上

*dashboard-admin 拥有k8s api-server所有权限

kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

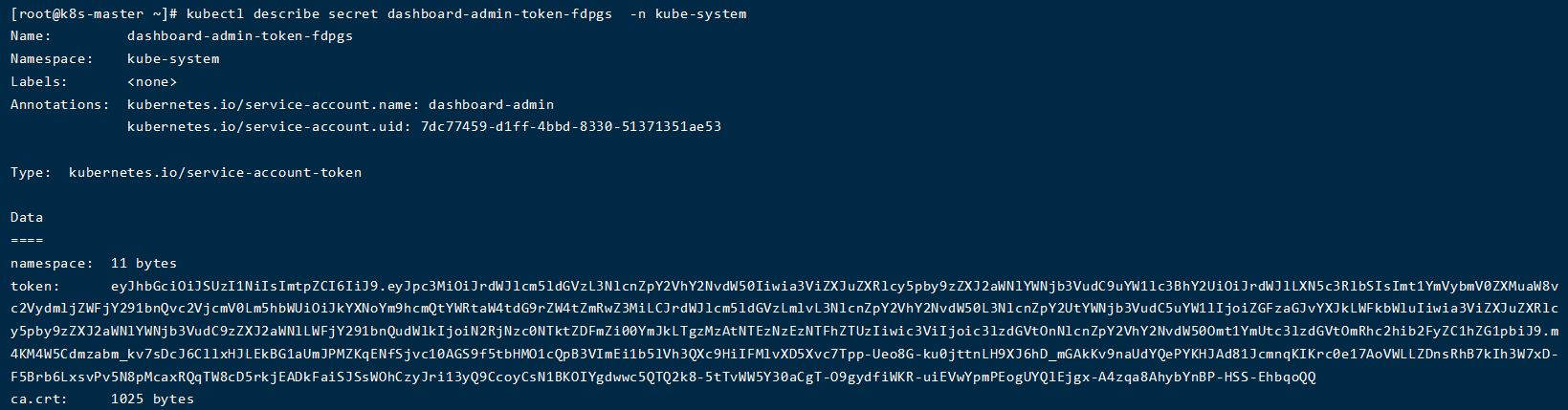

7.查看dashboard-admin用户的securet:

kubectl get secret -n kube-system

kubectl describe secret dashboard-admin-token-fdpgs -n kube-system

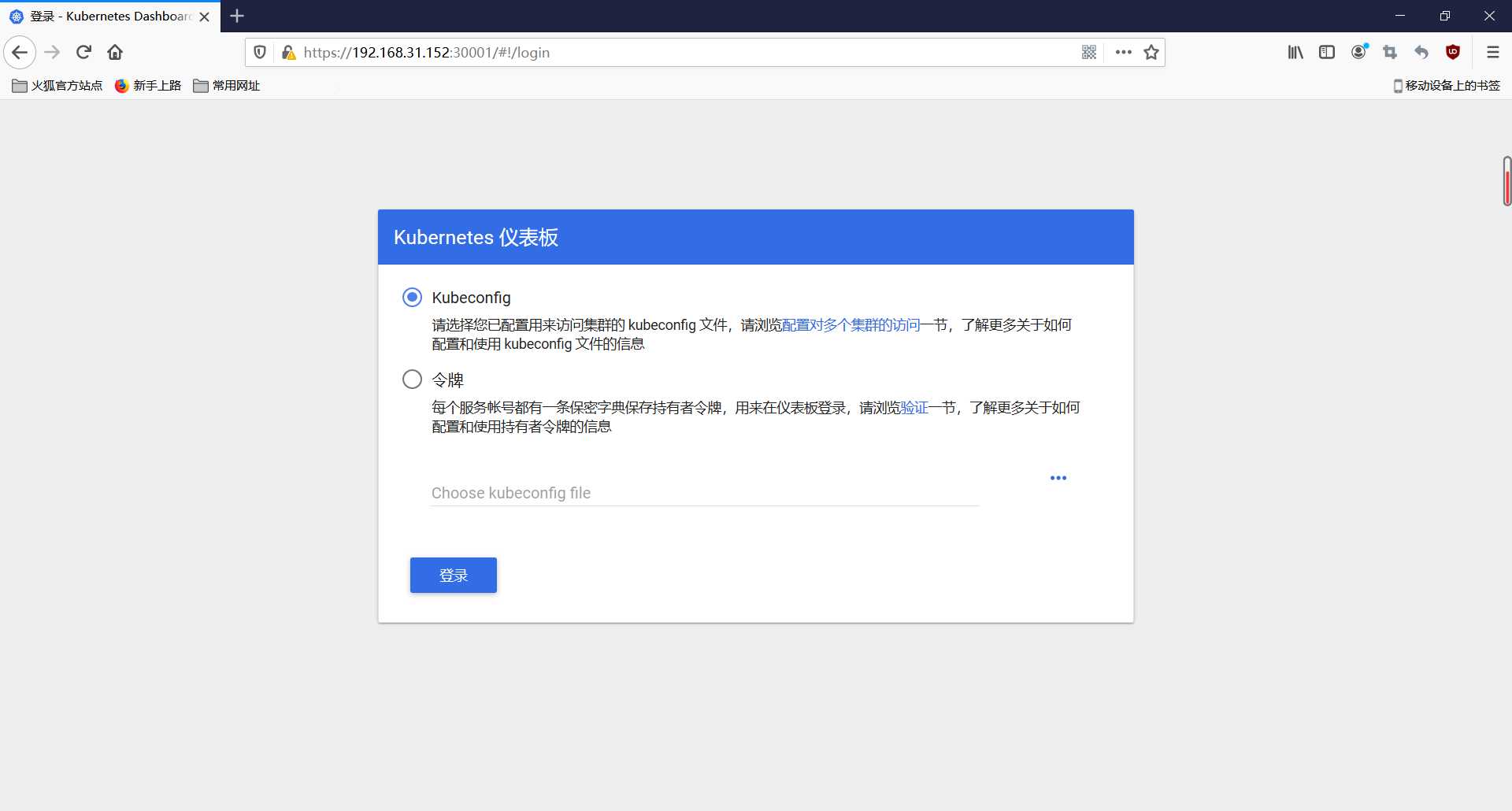

七、登录UI查看效果

1)通过“火狐浏览器”登录https://192.168.31.152:30001

2)输入token

大功告成!

如果觉得小名的文章帮助到了您,请关注小名,支持一下小名😄,给小名的文章点赞👍、评论✍、收藏🤞谢谢大家啦~♥♥♥

免责声明:本站所有文章内容,图片,视频等均是来源于用户投稿和互联网及文摘转载整编而成,不代表本站观点,不承担相关法律责任。其著作权各归其原作者或其出版社所有。如发现本站有涉嫌抄袭侵权/违法违规的内容,侵犯到您的权益,请在线联系站长,一经查实,本站将立刻删除。 本文来自网络,若有侵权,请联系删除,如若转载,请注明出处:https://yundeesoft.com/12840.html